Na primeira e segunda parte falei-vos de múltiplos problemas que perturbam a ciência actual, nomeadamente na forma como é transmitida, bem como no sistema de investigação em vigor. Nesta terceira e última parte vou-me focar naquele que é talvez o aspecto mais importante na filosofia científica e que tem vindo a ser descurado sistematicamente: a replicabilidade.

Nascemos neste mundo sem nada saber sobre ele (ver ressalva*). Se nada nos for ensinado, poderemos eventualmente começar a fazer constatações: um objecto atirado ao ar cai; o Sol aparece periodicamente no céu; todos os animais têm quatro membros; etc. Estas observações transformam-se na representação abstracta que temos do mundo, isto é, são os pedaços de informação que identificámos para caracterizar o meio ao nosso redor. Um dia encontramos um peixe e verificamos que afinal uma das nossas observações estava incompleta. Verificamos também que na verdade a permanência do Sol no céu vai variando de um período para o seguinte, o que significa que o período inicialmente identificado (dia) é modulado por uma outra escala temporal mais lenta (ano), também ela repetitiva. Observamos ainda que se lançarmos poeira ao ar ficamos sem saber se de facto a poeira chega a cair, ou não.

Só com estes exemplos simples torna-se de imediato evidente a necessidade de se ser metódico para poder tirar conclusões correctas sobre o universo. Repare-se como a existência de um só contra-exemplo nos levou logo à reformulação de uma constatação. De facto, por mais animais que encontremos com quatro membros, basta encontrar um que não tenha quatro para que a “definição” de animais tenha que ser repensada. Também a noção de que qualquer objecto cai parece ter que ser melhor definida para que possamos verificá-la. Note-se também aqui a importância dos meios que temos ao nosso dispor para testar uma dada hipótese! De facto, o nosso conhecimento está claramente dependente dos meios técnicos que temos num dado momento. Do mesmo modo que um cego não sabe o que são cores, também uma pessoa do século XIX poderia ser céptica quanto à possibilidade de enviar uma sonda para o espaço…

Por vezes constatamos fenómenos raros que nunca tínhamos observado. A nossa perplexidade decorre de presenciarmos algo que não sabíamos que existia. Se contarmos o que vimos a outra pessoa, é possível que ela não acredite em nós, caso nunca tenha observado o fenómeno. Como convencê-la? É necessário mostrar-lhe! Para isso teremos que eventualmente compreender o fenómeno para que possamos voltar a encontrá-lo. Se não conseguirmos voltar a encontrá-lo, como saber se de facto aconteceu? Terá sido uma alucinação? Um sonho? Estaremos a mentir? É por isto que supostos milagres não fazem parte da ciência, por não poderem ser repetidos quando se desejar.

A replicabilidade científica é portanto absolutamente crucial, pois sem ela a ciência não poderia responder às questões cépticas que a conduz a novas respostas. A replicabilidade na ciência actual torna-se ainda mais necessária quando se considera as falhas que apontei na primeira e segunda parte deste artigo. De facto, no ano passado a “Open Science Collaboration” publicou um artigo que mostra o quão problemático é esta questão em Psicologia, pois de uma tentativa de replicar 100 estudos, conseguiram apenas replicar os resultados de um terço! Já este ano fez-se um questionário a 1500 cientistas que mostra que existe uma preocupação significativa na comunidade científica (em particular em ciências biomédicas e ciências sociais), com 52% a concordar que a ciência está em crise devido à falta de replicabilidade.

Como já antes indiquei, é difícil publicar um artigo cujo conteúdo não seja novo. Parece não haver mérito em conseguir repetir o que outros já fizeram, e nem parece haver necessidade de fazer uma nova publicação a constatar algo que já é conhecido. De facto, é sempre mais fácil copiar do que “inventar”, pelo que sem dúvida que o mérito é inferior. E também é verdade que parece desnecessário reportar a mesma coisa mais que uma vez, pois parece não trazer nada de novo. Não é verdade. A evidência científica é cumulativa! Em estudos de carácter estatístico, em particular, este aspecto é muito relevante. O sistema científico deveria funcionar em função do desenvolvimento da ciência, mas neste caso tal não sucede. O conhecimento tem que ser uno, encarando as evidências como um todo. Em contraste, no sistema científico temos estudos independentes que se comparam entre si, mas que não se “somam”. É por isso possível ter dois estudos que testaram a mesma hipótese, mas cuja conclusão é diferente (estatisticamente significativa em ambos). Idealmente, os dados de ambos os estudos deveriam ser considerados em conjunto e não apenas de forma antagónica! A razão pela qual tal não acontece já foi mencionada na segunda parte: não existe ainda uma cultura de partilha de dados recolhidos. (Naturalmente, também é necessário admitir limitações metodológicas, pois nem sempre é claro de que forma é que os dados de dois ou mais estudos podem ser integrados.)

Mesmo que comece a haver incentivos para replicar estudos, tal não implica que o problema esteja de imediato resolvido. De um ponto de vista prático, o primeiro passo para a replicabilidade seria usar os mesmos métodos e dados para verificar se se chega à mesma conclusão. Se tal não acontecer, algo deve estar errado. O segundo passo concerne obter novos dados e voltar a aplicar a mesma metodologia. Os resultados mantém-se? Quais os desvios aceitáveis? Note-se que em muitos casos o tópico de estudo não é determinista, e como tal é expectável um dado grau de variabilidade. Quão grande? Como distingui-lo de outros erros estatísticos expectáveis? E se existir ruído? Que critérios estatísticos devemos usar para comparar dois estudos? De que forma é que devemos considerar os dados em conjunto? Todas estas questões podem ser difíceis de responder! Torna-se assim bastante difícil definir se o resultado do segundo estudo está ou não de acordo com o primeiro! Mais uma vez recordo que raramente estamos a comparar o preto com o branco! Dois tons de cinzento podem ser muito parecidos, mas como podemos definir que são estatisticamente equivalentes? Note-se que ainda só vamos no segundo passo! O terceiro passo será considerar diferentes métodos para testar a mesma hipótese. A comparação torna-se ainda mais complexa porque diferentes métodos podem fazer caracterizações diferentes dos dados e como tal as respostas podem ser diferentes simplesmente porque já não correspondem de facto à mesma questão (note-se que neste contexto a utilização de um dado método consiste numa forma de “questionar” os dados).

É ainda importante constatar que tudo se complica ainda mais quando consideramos o problema em maior detalhe: muitos estudos publicados não dão um nível de detalhe suficientemente esclarecedor para que sejam replicados (os revisores muitas vezes nem o notam simplesmente porque não tentam replicar). Muitos detalhes negligenciados e “ocultados” podem ter um papel preponderante sem que se saiba: máquinas usadas em diferentes laboratórios podem dar pequenos erros sistemáticos diferentes, nomeadamente no que diz respeito a calibrações; certos produtos usados (como seja reagentes químicos) têm variabilidade; e até as condições em que se fez o estudo podem-no condicionar por completo (em bioquímica poderemos ter que considerar a altura do dia em que foi realizado, temperatura, humidade, etc; em ciências sociais não poderemos esquecer que o tempo e espaço são muito significativos, pois, por exemplo, um estudo sobre a opinião da população no que toca ao acolhimento de refugiados pode mudar de um dia para o outro, caso haja um atentado terrorista; neste exemplo é bastante evidente o porquê de um estudo não ser directamente comparável a outro, mas infelizmente nem sempre é assim tão evidente).

Por fim, não esqueçamos que a investigação é feita por pessoas “humanas”, o que implica que a comunicação entre cientistas nem sempre seja a melhor. Por exemplo, um cientista poderá não querer questionar outro para não parecer incompetente, ou para não parecer que está a colocar em causa o trabalho dessa pessoa. Uma questão mal feita pode parecer uma acusação! Mais, quando se trata de não conseguir replicar o que outros fizeram, dá a ideia que se está a acusar esses outros de negligência ou fraude. Numa disputa, a reputação dos intervenientes pode ficar em jogo, e consequentemente carreiras científicas podem ser destruídas. Recordo ainda que a competição entre cientistas conduz a secretismo. Assim, um cientista pode evitar comunicar com outro para que esse outro não descubra o que ele planeia investigar, para que não corra o risco de ser ultrapassado.

Não obstante tudo isto, há um aspecto positivo que decorre da publicação de potenciais falsidades: novas questões e interpretações podem surgir, e consequentemente novas experiências podem conduzir a conhecimento novo. A probabilidade de questionar o inverosímil aumenta, e com isto aumentam também as oportunidades de tropeçar em novos factos. Assim, caminhos falsos podem-nos levar a novos destinos, e a novas verdades.

Como podem imaginar, ficou muito por dizer. Podem ler mais sobre o tema no seguinte artigo em inglês: The 7 biggest problems facing science, according to 270 scientists.

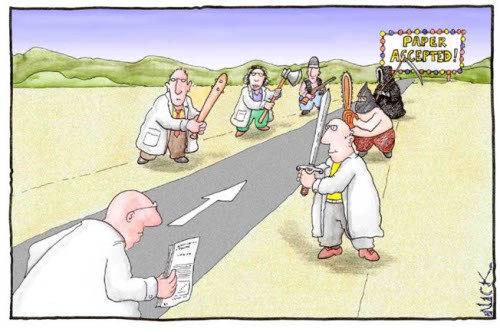

Este cartoon ilustra o aparente objectivo dos cientistas actuais: fazer com que o seu artigo seja publicado, conseguindo ultrapassar a resistência dos revisores. Contribuir para o progresso da ciência tornou-se num mero subproduto deste sistema!

*Esta asserção pode ser questionada, pois a verdade é que nascemos já com muitas predisposições “optimizadas” a este mundo, as quais podem ser consideradas como sendo um pré-conhecimento genético. Por exemplo, se bebermos água não potável é provável que a reconheçamos como desagradável ao paladar, o que nos conduzirá a evitá-la de futuro.

Últimos comentários